NVIDIA anuncia TensorRT-LLM: software de inferencia para acelerar el procesamiento de AI

Empresas como d-Matrix están incursionando en el lucrativo mercado de la inteligencia artificial con infraestructura de inferencia codiciada. En respuesta, el líder en IA, NVIDIA, anunció hoy el software TensorRT-LLM, una biblioteca de tecnología de inferencia LLM diseñada para acelerar el procesamiento de inferencia de IA.

¿Qué es TensorRT-LLM?

TensorRT-LLM es una biblioteca de código abierto que se ejecuta en las GPUs NVIDIA Tensor Core. Está diseñada para brindar a los desarrolladores un espacio para experimentar con la creación de nuevos modelos de lenguaje grandes, la base de la IA generativa como ChatGPT.

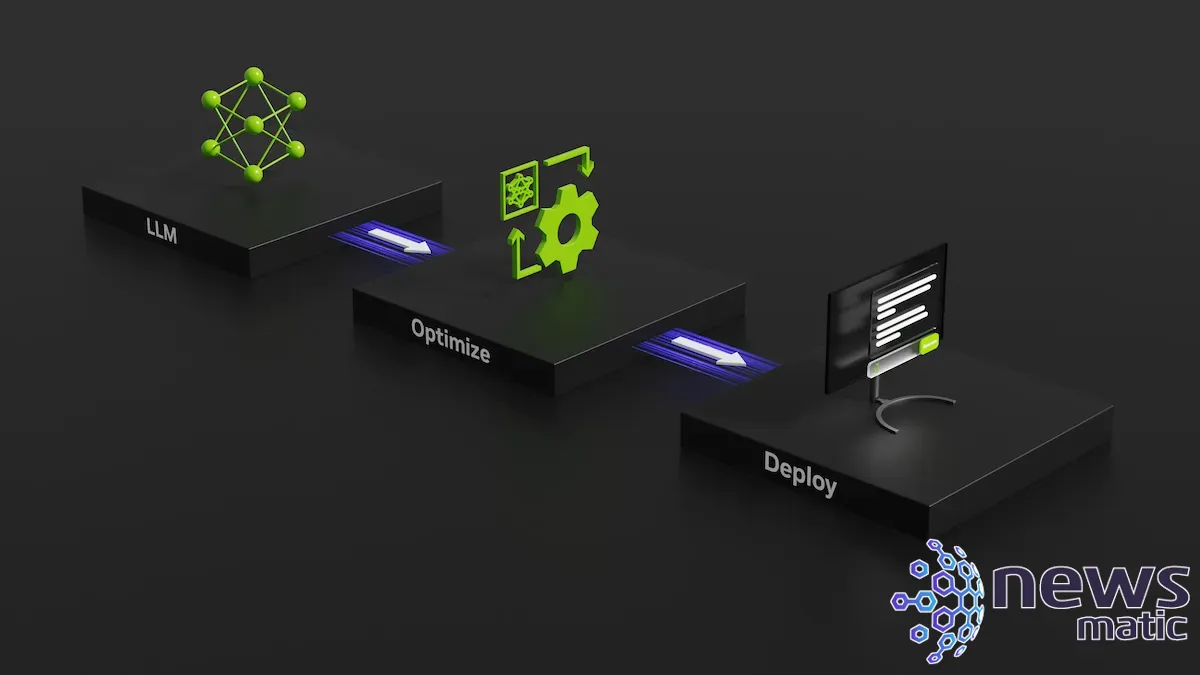

En particular, TensorRT-LLM abarca la inferencia, que es una mejora del entrenamiento de la IA o la forma en que el sistema aprende a conectar conceptos y hacer predicciones, y también define, optimiza y ejecuta LLMs. El objetivo de TensorRT-LLM es acelerar la velocidad de la inferencia en las GPUs de NVIDIA.

TensorRT-LLM se utilizará para construir versiones de los LLMs más avanzados en la actualidad, como Meta Llama 2, OpenAI GPT-2 y GPT-3, Falcon, Mosaic MPT, BLOOM y otros.

Para lograr esto, TensorRT-LLM incluye el compilador de aprendizaje profundo TensorRT, núcleos optimizados, pre y post-procesamiento, comunicación multi-GPU y multi-nodo, y una interfaz de programación de aplicaciones de Python de código abierto.

NVIDIA destaca que una parte atractiva de TensorRT-LLM es que los desarrolladores no necesitan un profundo conocimiento de C++ o NVIDIA CUDA para trabajar con ella.

El sueño se hace realidad: Salesforce amplía Einstein AI y Data Cloud Platform en Dreamforce 2023

El sueño se hace realidad: Salesforce amplía Einstein AI y Data Cloud Platform en Dreamforce 2023“TensorRT-LLM es fácil de usar, está cargado de funciones como transmisión de tokens, agrupamiento en vuelo, atención paginada, cuantización y más, y es eficiente”, afirmó Naveen Rao, vicepresidente de ingeniería de Databricks, a NVIDIA en el comunicado de prensa. "Ofrece un rendimiento de vanguardia para la implementación de LLM utilizando GPUs de NVIDIA y nos permite transmitir los ahorros de costos a nuestros clientes".

Databricks fue una de las empresas que tuvo acceso anticipado a TensorRT-LLM.

El acceso anticipado a TensorRT-LLM está disponible ahora para las personas que se han registrado en el Programa de Desarrolladores de NVIDIA. Según el comunicado de prensa inicial, NVIDIA afirma que estará disponible para un lanzamiento más amplio "en las próximas semanas".

¿Cómo mejora TensorRT-LLM el rendimiento en las GPUs de NVIDIA?

Los LLMs que realizan la resumización de artículos lo hacen más rápido en TensorRT-LLM y una GPU NVIDIA H100 en comparación con la misma tarea en un chip NVIDIA A100 de generación anterior sin la biblioteca LLM, según NVIDIA. Con solo el H100, el rendimiento de inferencia de GPT-J 6B LLM experimentó una mejora de 4 veces. El software TensorRT-LLM proporcionó una mejora de 8 veces.

En particular, la inferencia se puede realizar rápidamente porque TensorRT-LLM utiliza una técnica que divide diferentes matrices de pesos entre dispositivos. (El ponderado enseña a un modelo de IA qué neuronas digitales deben estar asociadas entre sí). Conocida como paralelismo tensorial, esta técnica permite realizar inferencias en paralelo en múltiples GPUs y en múltiples servidores al mismo tiempo.

El agrupamiento en vuelo mejora la eficiencia de la inferencia, según NVIDIA. En pocas palabras, los lotes completos de texto generado pueden producirse uno por uno en lugar de todos a la vez. El agrupamiento en vuelo y otras optimizaciones están diseñados para mejorar el uso de la GPU y reducir el costo total de propiedad.

Aprende Machine Learning desde cero con el Programa E-Degree para Principiantes Absolutos en 2023.

Aprende Machine Learning desde cero con el Programa E-Degree para Principiantes Absolutos en 2023.El plan de NVIDIA para reducir el costo total de propiedad de la IA

El uso de LLMs es costoso. De hecho, según NVIDIA, los LLMs cambian la forma en que los centros de datos y el entrenamiento de IA se ajustan a la hoja de balance de una empresa. La idea detrás de TensorRT-LLM es que las empresas podrán construir IA generativa compleja sin que el costo total de propiedad se dispare.

En Newsmatic nos especializamos en tecnología de vanguardia, contamos con los artículos mas novedosos sobre Inteligencia artificial -, allí encontraras muchos artículos similares a NVIDIA anuncia TensorRT-LLM: software de inferencia para acelerar el procesamiento de AI , tenemos lo ultimo en tecnología 2023.

Artículos Relacionados