Apache Spark vs. Apache Hadoop: Cuál es la mejor herramienta de ciencia de datos

Apache Spark y Apache Hadoop son dos herramientas de ciencia de datos muy populares y de código abierto ofrecidas por la Fundación Apache. Desarrolladas y respaldadas por la comunidad, continúan creciendo en popularidad y funcionalidades.

Apache Spark está diseñado como una interfaz para el procesamiento a gran escala, mientras que Apache Hadoop brinda un marco de software más amplio para el almacenamiento y procesamiento distribuido de big data. Ambos se pueden utilizar juntos o como servicios independientes.

¿Qué es Apache Spark?

Apache Spark es un motor de procesamiento de datos de código abierto diseñado para el análisis eficiente de datos a gran escala. Un motor de análisis unificado robusto, Apache Spark se utiliza con frecuencia por los científicos de datos para respaldar algoritmos de aprendizaje automático y análisis de datos complejos. Se puede ejecutar tanto de forma independiente como como un paquete de software sobre Apache Hadoop.

¿Qué es Apache Hadoop?

Apache Hadoop es una colección de módulos y utilidades de código abierto destinados a facilitar el proceso de almacenamiento, gestión y análisis de big data. Sus módulos incluyen Hadoop YARN, Hadoop MapReduce y Hadoop Ozone, pero también admite numerosos paquetes de software de ciencia de datos opcionales. Apache Hadoop se puede utilizar indistintamente para hacer referencia a Apache Spark y otras herramientas de ciencia de datos.

Tabla comparativa: Spark vs. Hadoop

| Características | Apache Spark | Apache Hadoop |

|---|---|---|

| Procesamiento por lotes | Sí | Sí |

| Streaming | Sí | No |

| Fácil de usar | Sí | No |

| Caché | Sí | No |

Precios de Spark y Hadoop

Es importante tener en cuenta que, si bien Apache Spark en sí mismo es gratuito y de código abierto, el costo total de propiedad puede aumentar significativamente al considerar el costo de los recursos en la nube, especialmente para tareas de procesamiento de datos a gran escala. Además, si requieres soporte profesional, es posible que debas invertir en una distribución comercial de Spark, lo cual tiene un costo adicional.

Al igual que Spark, Apache Hadoop es un proyecto de código abierto y de uso gratuito. Sin embargo, si deseas utilizar Hadoop en la nube o optar por una distribución de Hadoop como Cloudera o Hortonworks, habrá costos asociados. Además, algunos distribuciones de Hadoop pueden incluir características adicionales que no están disponibles en la versión de código abierto.

Cómo compartir y explicar informes de Power BI en PowerPoint

Cómo compartir y explicar informes de Power BI en PowerPointComparación de características: Spark vs. Hadoop

Procesamiento por lotes

El procesamiento por lotes de Spark es altamente eficiente debido a sus capacidades de cómputo en memoria. Esto hace que Spark sea una excelente opción para tareas que requieren múltiples operaciones en el mismo conjunto de datos, ya que puede realizar estas operaciones en memoria, reduciendo significativamente el tiempo necesario. Sin embargo, este procesamiento de alta velocidad puede implicar un mayor uso de memoria.

Por otro lado, Hadoop está diseñado para el procesamiento por lotes de alto rendimiento. Excela en el almacenamiento y procesamiento de grandes conjuntos de datos en clústeres de computadoras utilizando modelos de programación simples. Aunque Hadoop puede ser más lento que el procesamiento en memoria de Spark, su procesamiento por lotes es altamente escalable y confiable, lo que lo convierte en una buena opción para tareas que requieren el procesamiento de conjuntos de datos muy grandes.

Streaming

Spark Streaming (Figura A) es una extensión de la API principal de Spark que permite el procesamiento de datos en tiempo real. Ingesta datos en mini-lotes y realiza transformaciones de RDD (conjuntos de datos distribuidos y resilientes) en esos mini-lotes de datos. Sin embargo, debido a que procesa datos en mini-lotes, puede haber una ligera demora, lo que significa que no es realmente en tiempo real.

Figura A

Hadoop en sí no admite el procesamiento de datos en tiempo real. Sin embargo, se puede lograr el procesamiento en tiempo real con componentes adicionales como Apache Storm o Apache Flink, aunque la integración de estos componentes adicionales puede agregar complejidad al ecosistema de Hadoop.

Las mejores formas de compartir y exportar tus dashboards en Tableau

Las mejores formas de compartir y exportar tus dashboards en TableauFácil de usar

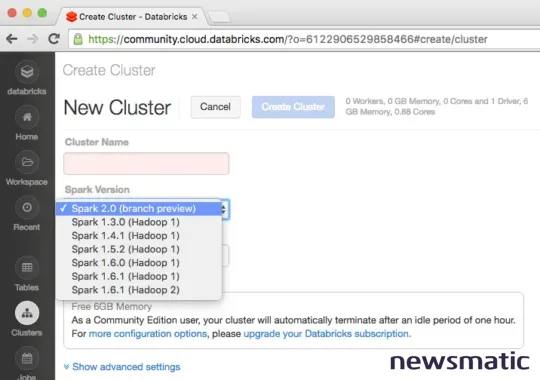

Debido a su enfoque más estrecho en comparación con Hadoop, Spark es más fácil de aprender. Apache Spark tiene algunos módulos principales y ofrece una interfaz limpia y sencilla (Figura B) para la manipulación y análisis de datos. Como Apache Spark es un producto bastante simple, la curva de aprendizaje es leve.

Figura B

Apache Hadoop es mucho más complejo. La dificultad de uso dependerá de cómo un desarrollador instala y configura Apache Hadoop y qué paquetes de software elige incluir. En cualquier caso, Apache Hadoop tiene una curva de aprendizaje mucho más significativa, incluso de manera predeterminada.

Velocidad

Para la mayoría de las implementaciones, Apache Spark será significativamente más rápido que Apache Hadoop. Construido para la velocidad, Spark puede superar a Hadoop en casi 100 veces la velocidad. Sin embargo, esto se debe a que Spark es un orden de magnitud más simple y ligero.

Por defecto, Apache Hadoop no será tan rápido como Apache Spark. Sin embargo, su rendimiento puede variar según los paquetes de software instalados y el almacenamiento, mantenimiento y análisis de datos involucrados.

Cómo eliminar filas en blanco en Excel sin destruir datos (tutorial)

Cómo eliminar filas en blanco en Excel sin destruir datos (tutorial)Seguridad y tolerancia a fallas

Cuando se instala como un producto independiente, Apache Spark tiene menos características de seguridad y tolerancia a fallas directamente disponibles que Apache Hadoop. Sin embargo, Apache Spark tiene acceso a muchas de las mismas utilidades de seguridad que Apache Hadoop, como la autenticación Kerberos; solo es necesario instalarlas y configurarlas.

En comparación, Apache Hadoop tiene un modelo de seguridad nativo más amplio y es ampliamente tolerante a fallos por diseño. Al igual que Apache Spark, su seguridad se puede mejorar aún más mediante otras utilidades de Apache.

Lenguajes de programación

Apache Spark admite Scala, Java, SQL, Python, R, C# y F#. Inicialmente se desarrolló en Scala, pero desde entonces ha implementado el soporte para casi todos los lenguajes populares que utilizan los científicos de datos.

Apache Hadoop está escrito en Java, con partes escritas en C. Las utilidades de Apache Hadoop admiten otros lenguajes, lo que lo hace adecuado para científicos de datos de todos los niveles de habilidad.

Pros y contras de Spark

Pros de Spark

- Las capacidades de procesamiento en memoria de Spark lo hacen más rápido que Hadoop para muchas tareas de procesamiento de datos.

- Spark proporciona APIs de alto nivel, lo que facilita su uso en comparación con Hadoop.

- A diferencia de Hadoop, Spark admite el procesamiento de datos en tiempo real.

Contras de Spark

- El procesamiento en memoria de Spark puede consumir mucha memoria, lo que puede ser una limitación para tareas con conjuntos de datos grandes.

- Aunque Spark está creciendo rápidamente, su ecosistema no es tan maduro como el de Hadoop.

- Aunque Spark en sí es gratuito, los costos asociados con los recursos en la nube y las distribuciones comerciales pueden ser altos.

Pros y contras de Hadoop

Pros de Hadoop

- Hadoop es altamente escalable y puede manejar grandes volúmenes de datos en muchos servidores.

- Hadoop es tolerante a fallos, lo que significa que está diseñado para funcionar incluso cuando algunos servidores fallan.

- Hadoop puede manejar datos estructurados y no estructurados, lo que lo hace versátil para varias tareas de procesamiento de datos.

Contras de Hadoop

- Hadoop puede ser complejo de configurar y administrar, especialmente para principiantes.

- Su modelo de procesamiento por lotes puede ser más lento que el procesamiento en memoria de Spark para ciertas tareas.

- Hadoop no admite el procesamiento de datos en tiempo real, lo que puede ser una limitación para algunos casos de uso.

Metodología de revisión

Analizamos minuciosamente las características, precios, facilidad de uso, soporte de la comunidad y rendimiento de cada producto. También tuvimos en cuenta las opiniones verificadas de los usuarios y la reputación de ambos productos en la industria para proporcionar una comparación equilibrada e imparcial.

¿Debería tu organización usar Spark o Hadoop?

Si eres un científico de datos que trabaja principalmente con algoritmos de aprendizaje automático y procesamiento de datos a gran escala, elige Apache Spark ya que:

Cómo usar Flash Fill y Power Query para analizar datos en Microsoft Excel

Cómo usar Flash Fill y Power Query para analizar datos en Microsoft Excel- Funciona como una utilidad independiente sin Apache Hadoop.

- Ofrece despacho de tareas distribuido, funciones de E/S y programación.

- Admite múltiples lenguajes, incluidos Java, Python y Scala.

- Ofrece paralelismo de datos implícito y tolerancia a fallos.

Si eres un científico de datos que requiere una amplia gama de utilidades de ciencia de datos para el almacenamiento y procesamiento de big data, elige Apache Hadoop, ya que:

- Ofrece un marco extenso para el almacenamiento y procesamiento de big data.

- Proporciona una increíble variedad de paquetes, incluido Apache Spark.

- Se basa en un sistema de archivos distribuido, escalable y portátil.

- Aprovecha aplicaciones adicionales para almacenamiento de datos, aprendizaje automático y procesamiento paralelo.

Si estás considerando una carrera en ciencia de datos, nuestro artículo "Cómo convertirse en científico de datos: una hoja de trucos" podría ser de tu interés.

En Newsmatic nos especializamos en tecnología de vanguardia, contamos con los artículos mas novedosos sobre Software, allí encontraras muchos artículos similares a Apache Spark vs. Apache Hadoop: Cuál es la mejor herramienta de ciencia de datos , tenemos lo ultimo en tecnología 2023.

Artículos Relacionados