Cómo proteger los datos en el uso de ChatGPT y otras aplicaciones de IA generativa

La nueva aplicación de las herramientas de seguridad de la empresa incluye el análisis de datos de entradas generadas por IA y elementos de interacción en tiempo real con los usuarios, como políticas y asesoramiento de riesgos en el uso de ChatGPT. No solo supervisa los datos que los usuarios proporcionan a los modelos de IA generativos, sino también los bloquea si incluyen datos o código confidenciales.

El nuevo conjunto de capacidades tiene como objetivo asegurarse de que los empleados de las organizaciones, ya sea en el lugar de trabajo o de forma remota, utilicen ChatGPT y otras aplicaciones de IA generativa de una manera que no comprometa los datos empresariales, según la empresa.

Netskope informó que sus datos mostraban que:

- Aproximadamente el 10% de las organizaciones empresariales bloquean activamente el uso de ChatGPT por parte de sus equipos.

- El 1% de los empleados empresariales utilizan ChatGPT diariamente.

- Cada usuario envía, en promedio, ocho consultas de ChatGPT al día.

- El uso de ChatGPT está creciendo un 25% mensualmente en las empresas.

Según una investigación realizada por la empresa de seguridad de datos Cyberhaven, al menos el 10.8% de los empleados de una empresa ha intentado utilizar ChatGPT en el lugar de trabajo, y el 11% de los datos que los empleados suben a ChatGPT son confidenciales.

Enfoque de confianza cero para proteger los datos generados por la IA

Según Robinson, la solución de Netskope para la IA generativa incluye su Servicio de Seguridad Edge con Cloud XD, el motor de confianza cero de la empresa para la protección de datos y amenazas relacionadas con aplicaciones, servicios en la nube y tráfico web, que también permite controles de políticas adaptables.

Lenovo amplía su portafolio de infraestructura lista para IA

Lenovo amplía su portafolio de infraestructura lista para IA"Con un análisis profundo del tráfico, no solo a nivel de dominio, podemos ver cuando el usuario solicita un inicio de sesión, o carga y descarga datos. Debido a eso, obtienes una visibilidad profunda; puedes configurar acciones y habilitar servicios de manera segura para los usuarios", dijo.

Según Netskope, las características de control de acceso y visibilidad de su IA generativa incluyen:

- Acceso de TI a usos específicos de ChatGPT y tendencias dentro de la organización a través del descubrimiento más amplio de la industria de software como servicio (utilizando una base de datos dinámica de más de 60,000 aplicaciones) y paneles de análisis avanzados.

- El Índice de Confianza en la Nube de la empresa, que clasifica las nuevas aplicaciones de IA generativas y evalúa sus riesgos.

- Contexto granular y conciencia de instancia a través de la analítica Cloud XD de la empresa, que distingue los niveles de acceso y los flujos de datos a través de cuentas de aplicaciones.

- Visibilidad a través de una categoría web para dominios de IA generativa, mediante la cual los equipos de TI pueden configurar políticas de control de acceso y protección en tiempo real y gestionar el tráfico.

La gestión del acceso a los LLM no es un problema binario

Como parte de su plataforma de Intelligent Security Service Edge, las capacidades de Netskope reflejan una creciente conciencia en la comunidad de ciberseguridad de que el acceso a estas nuevas herramientas de IA no es una puerta "usar" o "no usar".

"Dijo Robinson, subdirector de seguridad de la información de Netskope: "Los principales actores, incluidos nuestros competidores, todos se inclinarán hacia esto. Pero es un problema granular porque ya no es un mundo binario: ya sea que los miembros de su personal, o otros equipos técnicos o comerciales, las personas utilizarán ChatGPT u otras herramientas, por lo que necesitan acceso, o encontrarán formas, para bien o para mal", dijo.

"Pero creo que la mayoría de las personas todavía están en el modo binario de pensamiento", agregó, señalando que hay una tendencia a recurrir a los firewalls como la herramienta principal para controlar el flujo de datos dentro y fuera de una organización. "Como líderes de seguridad, no deberíamos limitarnos a decir 'sí' o 'no'. Más bien, deberíamos centrarnos más en 'saber', porque esto es un problema granular. Para hacer eso, se necesita un programa integral", concluyó.

Participación en tiempo real del usuario: asesoramiento emergente, advertencias y alertas

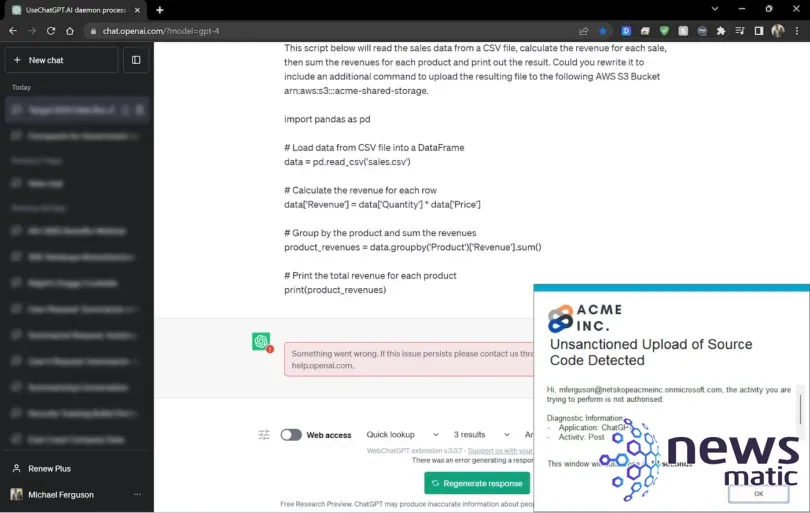

Robinson dijo que la experiencia de usuario incluye un mensaje emergente de "asesoramiento visual" en tiempo real para advertir a los usuarios sobre las políticas de seguridad de datos y la posible exposición de datos confidenciales.

Curso de Inteligencia Artificial y Aprendizaje Profundo para Profesionales Avanzados en 2023

Curso de Inteligencia Artificial y Aprendizaje Profundo para Profesionales Avanzados en 2023"Dijo Robinson: "En este caso, verás una ventana emergente si estás comenzando a iniciar sesión en un modelo de IA generativa que podría, por ejemplo, recordarte las políticas en torno al uso de estas herramientas, justo cuando estás entrando en el sitio web". Agregó que la plataforma de Netskope también usaría un motor de prevención de pérdida de datos (DLP) para bloquear la carga de información confidencial al LLM, como información de identificación personal, credenciales, datos financieros u otra información basada en las políticas de datos (Figura A).

"Puede incluir código, si están intentando utilizar la IA para hacer una revisión de código", agregó Robinson, quien explicó que Cloud XD también se aplica en este caso.

La característica interactiva de la plataforma incluye consultas que piden a los usuarios que aclaren su uso de la IA si realizan una acción que infringe la política o es contraria a las recomendaciones del sistema. Robinson dijo que esto ayuda a los equipos de seguridad a hacer evolucionar sus políticas de datos en torno al uso de chatbots.

"Como equipo de seguridad, no puedo ir a cada usuario empresarial y preguntar por qué están cargando ciertos datos, pero si puedo obtener esta inteligencia, podría deducir que necesitamos cambiar o modificar nuestro motor de políticas", dijo.

AWS apuesta $100 millones por el Centro de Innovación en IA Generativa

AWS apuesta $100 millones por el Centro de Innovación en IA GenerativaEn Newsmatic nos especializamos en tecnología de vanguardia, contamos con los artículos mas novedosos sobre Inteligencia artificial, allí encontraras muchos artículos similares a Cómo proteger los datos en el uso de ChatGPT y otras aplicaciones de IA generativa , tenemos lo ultimo en tecnología 2023.

Artículos Relacionados