NVIDIA anuncia supercomputadora DGX GH200 para IA y herramientas de red optimizadas

El 28 de mayo, en la conferencia COMPUTEX en Taipei, NVIDIA anunció una serie de nuevos equipos de hardware y herramientas de redes, muchos de ellos enfocados en habilitar la inteligencia artificial. La nueva línea incluye la supercomputadora DGX GH200, con una capacidad de cálculo de 1 exaflop; más de 100 opciones de configuración de sistemas diseñados para ayudar a las empresas a satisfacer sus necesidades de inteligencia artificial y computación de alto rendimiento; una arquitectura de referencia modular para servidores acelerados; y una plataforma de redes en la nube basada en Ethernet para la inteligencia artificial.

Estos anuncios, y la primera presentación pública que el cofundador y CEO Jensen Huang ha realizado desde el inicio de la pandemia de COVID-19, ayudaron a impulsar a NVIDIA hacia la codiciada capitalización de mercado de $1 billón. De lograrlo, se convertiría en el primer fabricante de chips en ascender al nivel de gigantes tecnológicos como Microsoft y Apple.

- ¿Qué hace que la DGX GH200 para supercomputadoras de inteligencia artificial sea diferente?

- Alternativas a los chips de supercomputación de NVIDIA

- La biblioteca empresarial que admite implementaciones de inteligencia artificial

- Redes más rápidas para la inteligencia artificial en la nube

- Próximamente: especificación del servidor MGX

- ¿Qué cambiará en la gestión de centros de datos?

- Otras noticias de NVIDIA en COMPUTEX

¿Qué hace que la DGX GH200 para supercomputadoras de inteligencia artificial sea diferente?

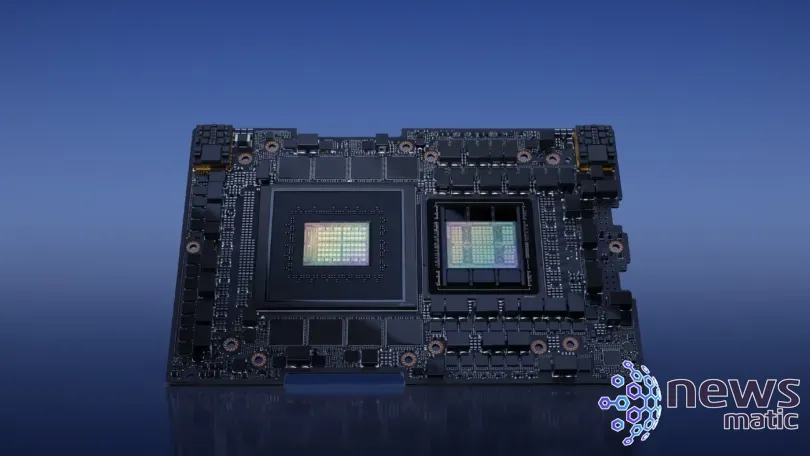

La nueva clase de supercomputadoras de inteligencia artificial de NVIDIA aprovecha los chips GH200 Grace Hopper Superchips y el sistema de interconexión NVIDIA NVLink Switch para ejecutar aplicaciones de lenguaje de inteligencia artificial generativo, sistemas recomendadores (motores de aprendizaje automático para predecir la valoración que un usuario podría dar a un producto o contenido) y cargas de trabajo de análisis de datos (Figura A). Es el primer producto que utiliza tanto los chips de alto rendimiento como la novedosa interconexión.

Figura A

Cómo simular un clic derecho desde el teclado en Windows

Cómo simular un clic derecho desde el teclado en WindowsNVIDIA ofrecerá primero la DGX GH200 a Google Cloud, Meta y Microsoft. Luego, planea ofrecer el diseño de la DGX GH200 como modelo para proveedores de servicios en la nube y otros hiperescaladores. Estará disponible a finales de 2023.

La DGX GH200 tiene como objetivo permitir que las organizaciones ejecuten inteligencia artificial desde sus propios centros de datos. Cada unidad cuenta con 256 superchips GH200 que proporcionan un rendimiento de 1 exaflop y una memoria compartida de 144 terabytes.

NVIDIA explicó en el anuncio que el sistema de interconexión NVLink permite que los chips GH200 eviten una conexión convencional PCIe entre la CPU y la GPU, aumentando el ancho de banda y reduciendo el consumo de energía.

"El entrenamiento de modelos de inteligencia artificial grandes es tradicionalmente una tarea intensiva en recursos y tiempo", dijo Girish Bablani, vicepresidente corporativo de infraestructura Azure de Microsoft, en el comunicado de prensa de NVIDIA. "El potencial de la DGX GH200 para trabajar con conjuntos de datos de terabytes permitiría a los desarrolladores realizar investigaciones avanzadas a mayor escala y a velocidades aceleradas".

NVIDIA también mantendrá parte de la capacidad de supercomputación para sí mismo; la compañía planea trabajar en su propia supercomputadora llamada Helios, impulsada por cuatro sistemas DGX GH200.

Alternativas a los chips de supercomputación de NVIDIA

No son muchas las compañías o clientes que buscan los niveles de velocidad de inteligencia artificial y supercomputación que los chips Grace Hopper de NVIDIA permiten. El principal competidor de NVIDIA es AMD, que produce el chip Instinct MI300. Este chip incluye tanto núcleos de CPU como de GPU, y se espera que ejecute la supercomputadora El Capitan de 2 exaflops.

10 atajos de teclado para Windows que debes conocer

10 atajos de teclado para Windows que debes conocerIntel ofrecía el chip Falcon Shores, pero recientemente anunció que no se lanzaría con núcleos tanto de CPU como de GPU. En cambio, ha cambiado el plan de desarrollo para centrarse en la inteligencia artificial y la computación de alto rendimiento, pero sin incluir núcleos de CPU.

La biblioteca empresarial que admite implementaciones de inteligencia artificial

Otro nuevo servicio, la biblioteca empresarial de inteligencia artificial de NVIDIA, está diseñado para ayudar a las organizaciones a acceder a la capa de software de las nuevas ofertas de inteligencia artificial. Incluye más de 100 marcos de trabajo, modelos preentrenados y herramientas de desarrollo. Estos marcos de trabajo son adecuados para el desarrollo e implementación de inteligencia artificial en producción, como inteligencia artificial generativa, visión por computadora, inteligencia artificial en el procesamiento del habla, entre otros.

El soporte bajo demanda de expertos en inteligencia artificial de NVIDIA estará disponible para ayudar en la implementación y escalado de proyectos de inteligencia artificial. Puede ayudar a implementar la inteligencia artificial en plataformas de centros de datos de VMware y Red Hat o en sistemas certificados por NVIDIA.

Redes más rápidas para la inteligencia artificial en la nube

NVIDIA quiere acelerar las redes basadas en Ethernet para la inteligencia artificial en la nube con la plataforma de redes aceleradas Spectrum-X (Figura B).

Figura B

Guía rápida para identificar diferentes tipos de chips de RAM

Guía rápida para identificar diferentes tipos de chips de RAM"NVIDIA Spectrum-X es una nueva clase de redes Ethernet que elimina las barreras para las cargas de trabajo de inteligencia artificial de próxima generación que tienen el potencial de transformar industrias enteras", dijo Gilad Shainer, vicepresidente senior de redes de NVIDIA, en un comunicado de prensa.

Spectrum-X puede admitir nubes de inteligencia artificial con 256 puertos de 200 Gbps conectados mediante un solo conmutador o 16,000 puertos en una topología de espina dorsal de dos niveles.

Spectrum-X logra esto utilizando Spectrum-4, un conmutador Ethernet de 51 Tbps construido específicamente para redes de inteligencia artificial. Las extensiones avanzadas de RoCE que combinan los conmutadores Spectrum-4, los DPU BlueField-3 y las ópticas NVIDIA LinkX crean una red de 400GbE de extremo a extremo optimizada para nubes de inteligencia artificial, según NVIDIA.

Spectrum-X y sus productos relacionados (conmutadores Spectrum-4, DPU BlueField-3 y ópticas LinkX de 400G) ya están disponibles, incluida la integración del ecosistema con Dell Technologies, Lenovo y Supermicro.

Próximamente: especificación del servidor MGX

En más noticias sobre rendimiento acelerado en centros de datos, NVIDIA ha lanzado la especificación del servidor MGX. Es una arquitectura de referencia modular para fabricantes de sistemas que trabajan en inteligencia artificial y computación de alto rendimiento.

"Creamos MGX para ayudar a las organizaciones a incorporar la inteligencia artificial empresarial", dijo Kaustubh Sanghani, vicepresidente de productos de GPU de NVIDIA, en un comunicado de prensa.

Cómo utilizar HyperTerminal para solucionar problemas con tu módem

Cómo utilizar HyperTerminal para solucionar problemas con tu módemLos fabricantes podrán especificar sus preferencias de GPU, DPU y CPU dentro de la arquitectura básica inicial del sistema. MGX es compatible con las formas de factor de servidor actuales y futuras de NVIDIA, incluidos 1U, 2U y 4U (refrigerados por aire o líquido).

SoftBank está trabajando en la construcción de una red de centros de datos en Japón que utilizarán los superchips GH200 y los sistemas MGX para servicios 5G y aplicaciones de inteligencia artificial generativa.

QCT y Supermicro han adoptado MGX y lo tendrán disponible en el mercado en agosto.

¿Qué cambiará en la gestión de centros de datos?

Para las empresas, añadir computación de alto rendimiento o inteligencia artificial a los centros de datos requerirá cambios en los diseños de infraestructura física y sistemas. Si y en qué medida hacerlo depende de la situación individual. Joe Reele, vicepresidente de arquitectos de soluciones de Schneider Electric, dijo en un correo electrónico a Newsmatic que muchas organizaciones grandes ya están en proceso de preparar sus centros de datos para la inteligencia artificial y el aprendizaje automático.

"La densidad de energía y la disipación de calor son los impulsores de esta transición", dijo Reele. "Además, la forma en que el kit de TI se arquitecta para la inteligencia artificial/aprendizaje automático en el espacio en blanco es otro factor a considerar, como la necesidad de recorridos de cables más cortos y agrupación".

Los operadores de centros de datos propiedad de empresas deben decidir en función de sus prioridades comerciales si reemplazar servidores y actualizar equipos de TI para admitir cargas de trabajo generativas de inteligencia artificial tiene sentido para ellos, dijo Reele.

Potencia y estilo en un solo equipo: Apple PowerBook G4

Potencia y estilo en un solo equipo: Apple PowerBook G4"Sí, los nuevos servidores serán más eficientes y tendrán más capacidad de cómputo, pero los operadores deben considerar elementos como la utilización del cómputo, las emisiones de carbono y, por supuesto, el espacio, la energía y la refrigeración. Si bien algunos operadores pueden necesitar ajustar sus estrategias de infraestructura de servidores, muchos no necesitarán realizar estas actualizaciones masivas en el corto plazo", dijo.

Otras noticias de NVIDIA en COMPUTEX

NVIDIA anunció una variedad de otros productos y servicios basados en la inteligencia artificial:

- WPP y NVIDIA Omniverse se unieron para anunciar un nuevo motor para marketing. El motor de contenido podrá generar videos e imágenes para publicidad.

- Una plataforma de fabricación inteligente, Metropolis for Factories, puede crear y gestionar sistemas personalizados de control de calidad.

- El Avatar Cloud Engine (ACE) para juegos es un servicio de fundición para desarrolladores de videojuegos. Permite que los personajes animados recurran a la inteligencia artificial para la generación de voz y animación.

En Newsmatic nos especializamos en tecnología de vanguardia, contamos con los artículos mas novedosos sobre Hardware, allí encontraras muchos artículos similares a NVIDIA anuncia supercomputadora DGX GH200 para IA y herramientas de red optimizadas , tenemos lo ultimo en tecnología 2023.

Artículos Relacionados